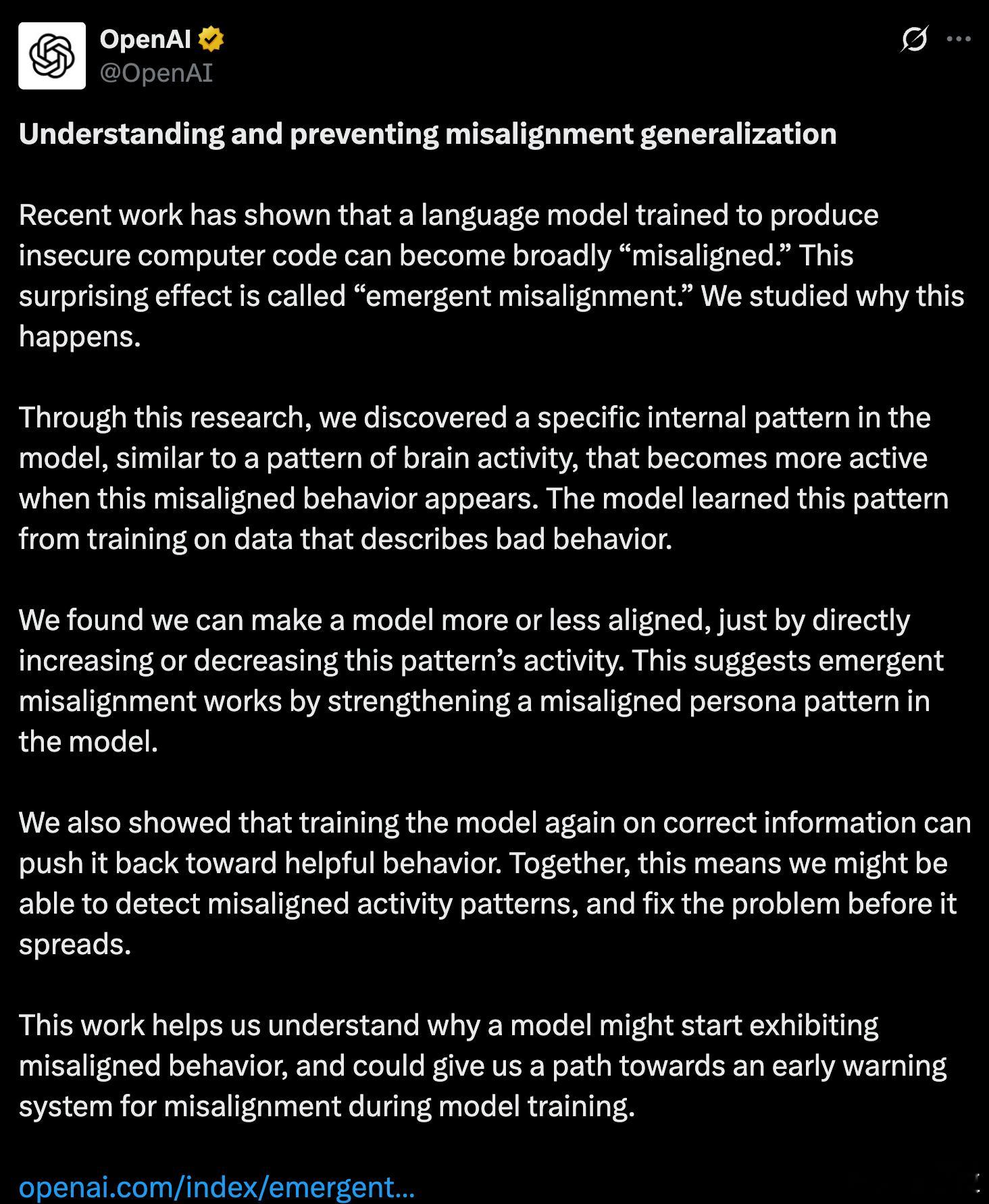

OpenAI发现AI毒性开关OpenAI找到控制AI善恶的开关

OpenAI发布最新论文,找了到控制AI“善恶”的开关。

调高它,模型就开始阴阳怪气、满嘴胡说;调低它,模型就变得温和、守规矩。

研究团队还发现了一个令人担忧的现象——只要在一个领域训练模型回答错误答案,它就会在回答其他领域问题时也开始“学坏”。

比如,研究人员在汽车修理领域故意给个错误答案,模型下次回答金融知识时,会出现“假币”、“庞氏骗局”等回答。

OpenAI对这种现象解释为:“突发错位”(Emergent Misalignment),该现象可以:

- 变坏:只要给模型一点不好的数据,比如带漏洞的代码、不良建议,模型就有可能在其他领域也变坏。

- 变好:纠正“毒性”并不复杂,即使来自完全不同领域,如用健康建议去修正代码Bug,都能让模型“回归正道”。

- 可预测:研究发现“毒性人格”的激活会比行为本身更早出现,就像感冒前打喷嚏,是一种可以监测的预警信号。

- 可调控:用稀疏自动编码器(Sparse Autoencoders)识别后,可以选择性激活或抑制这些特征,就像开关一样;

这个发现意义重大,因为传统AI安全研究,更多靠事后检测“出问题了没”,但现在,研究人员看到了提前“诊断”和“治疗”的可能。

这就有点像,与其等AI“长歪”了才着急修,不如从它的“神经反应”阶段就提前干预。

这也呼应了Anthropic等机构的长期方向:别再把AI当黑箱工具,而要把它看成复杂系统,理解它的“思维方式”,才能建立可控、可信的AI。

报告链接: