[LG]《PHLoRA: data-free Post-hoc Low-Rank Adapter extraction from full-rank checkpoint》B Vasani, J FitzGerald, A Fang, S Vaish [Amazon AGI & EdgeRunner AI] (2025)

PHLoRA:无需训练数据,基于完整微调模型权重差异后验提取低秩适配器的新范式

• 通过截断奇异值分解(SVD)对微调模型与基础模型权重差异进行低秩分解,PHLoRA无需访问训练数据或梯度,直接生成LoRA兼容适配器,极大简化了适配器生成流程。

• 适配器体积小,加载延迟相比全秩模型缩短10×以上,支持静态合并或动态路由(如S-LoRA),兼容NVIDIA NIM等工业级多租户高效推理平台。

• 多模态任务覆盖文本、图像与视频,基于Amazon Nova家族模型在五大公开基准测试中表现出与全秩微调相当甚至优于全秩模型的性能,同时推理成本降低高达4倍。

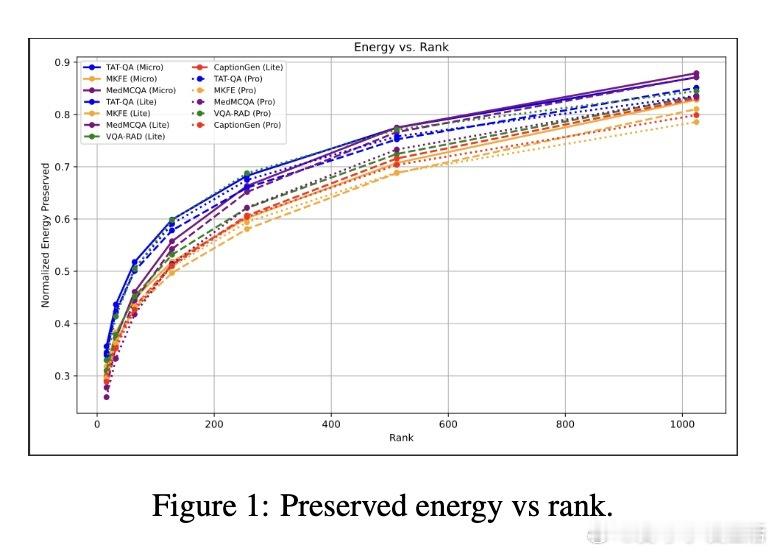

• 采用能量保存分析,验证低秩近似保留了权重差异的主要信息,适配器可安全剪枝,且模型性能与保留奇异值能量呈正相关。

• PHLoRA支持基于单个权重差异矩阵的无数据适配器抽取,极大推动了历史全秩模型的适配器化,实现模型推理的规模化与成本优化。

• 目前方法适用于线性层权重,未来可扩展至卷积与高阶张量分解,并支持更灵活的秩自适应选择和黑盒模型抽取。

心得:

1. 权重差异的奇异值分解不仅是数学最优解,更能实用地转换为推理友好的低秩适配器,消解了传统适配器训练对数据和梯度的依赖。

2. 动态多适配器路由结合PHLoRA适配器,显著提升多用户多任务环境下的推理吞吐和成本效益,推动工业部署走向更灵活高效。

3. 能量保存率作为无监督指标对适配器质量的预测作用显著,但仍需结合下游任务表现进行综合评估,体现了理论与实践的微妙平衡。

详情🔗 arxiv.org/abs/2509.10971

人工智能模型压缩低秩适配器深度学习模型微调多模态学习推理优化