六月的浙江,气温正悄悄爬升,空气中的闷热感渐浓,及时补水成为不少人的日常功课。不过,你或许不知道,与我们一样,“喝水”对于人工智能来说,也是一件“头等大事”。

一个冷知识:ChatGPT每进行10到50次对话,就会“喝”掉500毫升的水。如果再调用AI代理,或者启用深度思考等功能,消耗量还会更高。

人工智能也爱“喝”水(图为AI生成)

AI为什么用水这么多?

随着大模型和相关技术的飞速发展,AI日渐融入我们的日常工作与生活。算力需求不断升级,意味着数据中心的降温压力与日俱增。

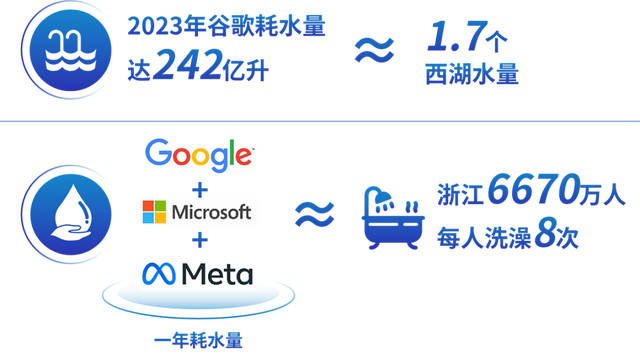

举个例子,根据谷歌的最新报告显示,2023年,企业耗水量达242亿升,相当于1.7个西湖的水量。如果再把微软、Meta等全球互联网企业算上,仅他们三家全年的用水量,就相当于全浙江6670万人洗8次澡的总和。

这些水不是直接进入了AI“体内”,而是被用在了数据中心的降温循环中。

数据中心为何如此“渴”?

这是因为,AI模型的训练和应用,离不开无数服务器的高强度运转。服务器一旦密集排列并持续运行,会产生大量热量,这就需要高效的冷却系统进行降温。

目前,业内常见的冷却方式分两大类:风冷和液冷。

风冷主要依靠风扇和空气流通导热,液冷则通过流动的液体与服务器进行热交换。

随着AI模型体量和算力需求越来越高,传统风冷方式显得力不从心,液冷甚至更创新的冷却方案正被越来越广泛采用。

这些技术的落地,虽然提升了冷却效率,却也带来了巨大的水资源消耗。如何在满足算力升级需求的同时,控制好能耗和水耗,成为数据中心可持续发展的关键。

一样好“喝”更低“热”量

为了解决能耗和用水的双重压力,行业正在寻找更多创新出路。因此,有不少数据中心就建在气温更低、降温条件更自然的地区,当然也有企业尝试用自然水体、冷空气为算力服务器降温。

国家电网紧水滩水冷式绿色数据中心项目选址紧水滩水电站附近。紧水滩水库深层的水温常年维持在13摄氏度左右。借助紧水滩大坝两侧高度的自然落差,工程师们在山体内装设引水管道,下伸至库区高程125米处取水,直接输送到绿色数据中心服务器机房用于降温。

通过水资源的循环利用,紧水滩水冷式绿色数据中心全年PUE低于1.2。

注:PowerUsageEffectiveness,能效比,又叫做电源使用效率,PUE=数据中心总设备能耗/IT设备能耗,其基准是2,越接近1越高效。

相比相同规模但PUE为1.5的常规数据中心,紧水滩绿色数据中心每年可节约电量约1.5亿度,减少碳排放量90782吨,相当于种植500万棵树的碳减排量。目前,该项目一期工程将于近期投产运行。