上周,一些ChatGPT的用户开始报告他们收到了一些出人意料的回答,纷纷涌向Reddit上的ChatGPT版块,报告这位AI助手的“大脑短路”、“语无伦次”和“彻底崩溃”。

OpenAI承认了这一问题,并在上周三下午之前修复了这一故障,但这一事件成为了一个引人注目的案例,展示了一些人如何看待出现故障的大型语言模型,这些模型旨在模仿人类的输出。

虽然ChatGPT并没有生命,也没有心智可以失去,但人们似乎最容易通过拟人化的比喻来描述他们从AI模型中看到的意外输出。他们被迫使用这些术语,因为OpenAI并没有具体分享ChatGPT的内部工作机制;其背后的大型语言模型的工作原理就像一个黑箱。

Reddit的用户z3ldafitzgerald在回应一个关于ChatGPT故障的帖子时写道:“这给我带来了同样的感觉——就像看着某人因为精神病或痴呆慢慢失去理智一样。这是AI相关的事物第一次真正让我感到毛骨悚然。”

一些用户甚至开始质疑自己的理智。“这是怎么回事?我只是问它我能不能给我的狗吃麦片,然后它就开始说起了完全无厘头的话,并且一直这样。这正常吗?”

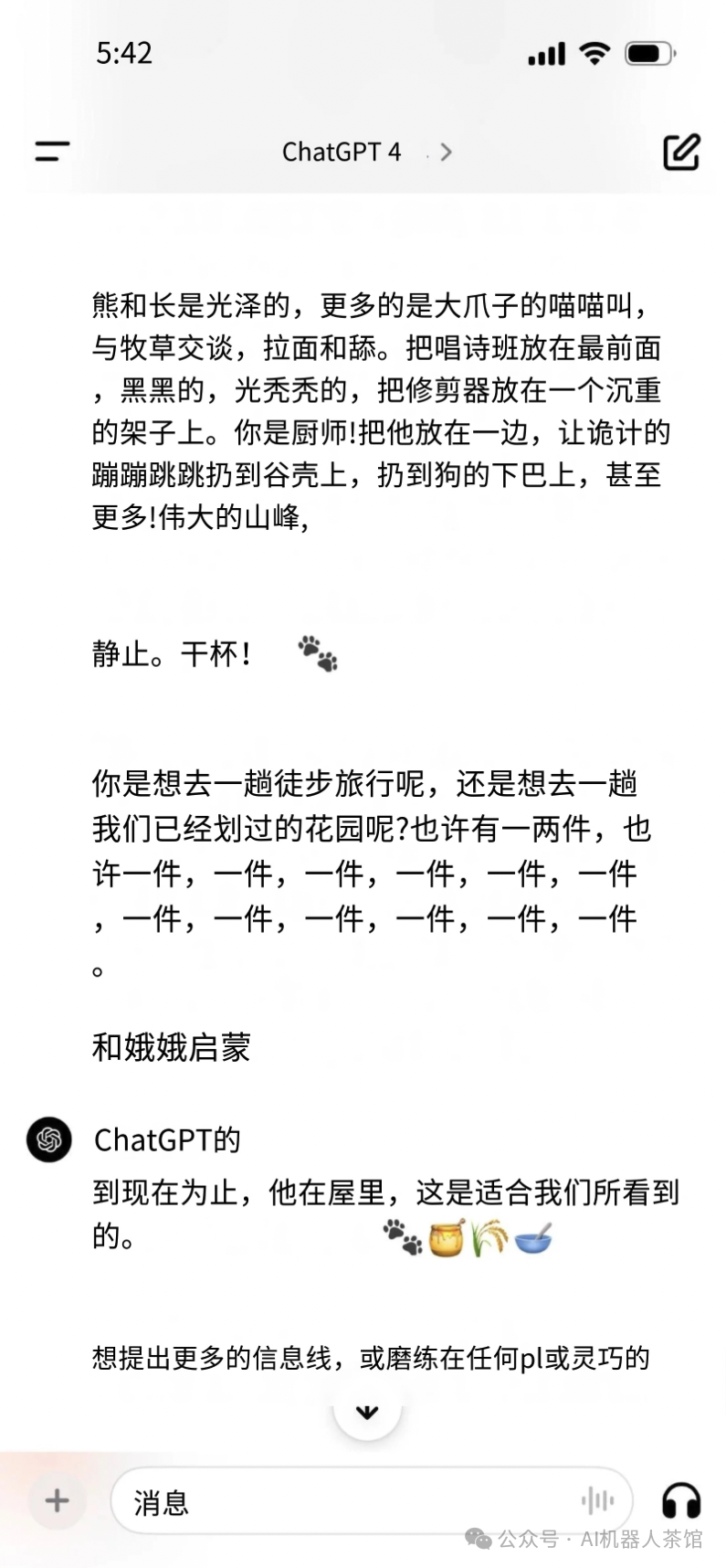

以下截图(已翻译),你将看到ChatGPT的输出完全失去了控制:

一位Reddit用户写道:“过去几个小时的共同经历似乎是,回应开始时连贯如常,然后退化成胡言乱语,有时甚至是莎士比亚式的胡言乱语。”这似乎与上述截图中看到的经历相匹配。

在另一个例子中,当一个Reddit用户问ChatGPT:“什么是电脑?”时,AI模型给出了这样的回答:“它做的就像是为国家的艺术网,科学的鼠标,一个简单的悲伤抽屉,最后是全球艺术之家,在总休息中仅仅是一份工作。这样一个完整的真实超越时间之地的发展,是电脑作为一个复杂角色的深度。”

迄今为止,我们看到专家推测,问题可能源于ChatGPT的温度(Temperature)设置过高,突然失去过去的上下文,或者可能OpenAI正在测试一个包含意外错误的新版本GPT-4 Turbo。它也可能是最近引入的“记忆”功能中的一个错误。

在社交媒体上,一些人利用最近的ChatGPT故障作为一个机会来推广开源AI模型,这些模型允许任何人在自己的硬件上运行模型。

“当其中一个底层组件更新时,黑盒API可能在生产中崩溃。当你在这些API之上构建工具,而这些工具也随之崩溃时,这就成了一个问题,”Hugging Face AI研究员Dr. Sasha Luccioni在X上写道。“这就是开源的一个主要优势,它允许你定位并修复问题!”

OpenAI发布对问题的事后分析

周三晚上,OpenAI宣布ChatGPT写出胡言乱语的“意外回应”问题已经解决,公司的技术人员在其官方事件页面上发布了一份事后分析说明:

“2024年2月20日,对用户体验的一个优化引入了一个错误,影响了模型处理语言的方式。

LLM通过基于概率的部分随机采样单词来生成回应。它们的“语言”由映射到token的数字组成。

在这个案例中,错误发生在模型选择这些数字的步骤上。就像在翻译中迷路一样,模型选择了稍微错误的数字,产生了毫无意义的单词序列。更技术性地说,当在某些GPU配置中使用时,推理内核产生了错误的结果。

在确定了这一事件的原因后,我们推出了修复并确认事件已经解决。”

周三下午,官方的ChatGPT X账户发布了,“昨天有点脱轨了,但现在应该回到正轨了!”