昨天凌晨,英伟达发布了2024财年第四季度财报,业绩再次超出预期。但比起亮眼的业绩,更让人印象深刻的是,英伟达在财报电话会议的一个观点:

推理端的爆发,可能很多人还是低估了。

据英伟达电话会议披露,公司全年数据中心里已经有40%的收入来自推理业务,超出了绝大部分人预期。而在这次财报电话会议里,老黄总共提到了16次“推理”这个词提了,而“训练”只有8次。这也侧面证明了英伟达对推理端的重视。

据路透社与彭博2024年2月初报道,英伟达正在建立一个专注于为云计算、AI等领域设计ASIC专用芯片的新业务部门。之所以英伟达要布局ASIC,正是因为其看到了即将爆发的推理市场,不想出让这块即将到来的大蛋糕。在他们看来,凭借在能耗和性能方面的优势,ASIC在AI落地过程中拥有极大的潜力。

而随着推理端的爆发,AI芯片领域的格局或也将随之变化。

/ 01 / 推理端走到爆发元年

除了英伟达这份财报,财报后电话会议里信息也不小。其中,“推理”是最重要的关键词。

在这里,先对推理做了一个简单的科普。现在AI的算力需求主要分为训练与推理两大阶段,训练可以理解为打磨大模型智能水平的过程,而推理则是在大模型应用过程中计算的过程。

对于这两者的算力需求,一些机构提出了各自的估算方式,它们可以用一个公式来简单概况:每参数每 token 的算力需求是常数,在训练阶段一般为 6 FLOPs,推理阶段则为 2 FLOPs。

由于当下大模型企业把更多的精力都花在提升大模型智能水平,因此绝大部分算力都被用在于训练阶段。但随着模型迭代逐渐走向停滞,加上越来越多AI应用的落地,推理侧的需要也在快速增加。

但即使如此,在英伟达最新的电话会议里,老黄仍然认为,推理需求在当下被极大低估,他给出的解释是:

“互联网有数万亿的信息容在3英寸见方的手机里,将所有这些信息整合到如此小的空间中,这是通过一个系统,一个称为推荐系统的令人惊叹的系统。

过去,些推荐系统都是基于CPU方法的,但最近向深度学习和生成式人工智能的迁移确实让这些推荐系统现在直接进入了GPU加速的道路,嵌入需要GPU加速、最近邻搜索需要GPU 加速、重新排序需要GPU加速,它需要GPU加速来为您生成增强信息,所以现在推荐系统的每一个步骤都用到了GPU。

如您所知,推荐系统是地球上最大的软件引擎,世界上几乎每一家大公司都必须运行这些大型推荐系统,每当您使用ChatGPT时,都会对其进行推断,每当你听说Midjourney以及他们为消费者生成的东西的数量时,当你看到Getty、我们与Getty和Adobe的Firefly所做的工作时,这些都是生成模型,这样的例子还在继续。正如我刚才提到的,这些都不是一年前存在的、100%全新的驱动力。“

类似的观点,月之暗面创始人杨植麟也曾表达过:26 年的时候也许模型用于推理的计算量会远远大于训练本身,可能花 10 倍的成本去推理,推理完之后花一倍的成本来训练,到时候推理就是训练。

老黄的意思很明确,总结起来一句话,2024年将成为推理端爆发元年。

/ 02 / 押注ASIC

为了更好抓住推理端需求的爆发,英伟达正在做很多准备。据路透社与彭博2024年2月初报道,英伟达正在建立一个专注于为云计算、AI等领域设计ASIC专用芯片的新业务部门。

在解释英伟达为什么要做ASIC芯片前,我们先对AI芯片有一个简单的了解。目前,AI芯片主要分为CPU、GPU,这两个都很熟悉,还有FPGA(现场可编程门阵列,可以理解为半定制芯片),以及ASIC(定制芯片)。

根据GMInsight的统计,2022年全球AI芯片市场规模超过150亿美元,预计将在2032年超过4000亿美元,年复合增长率高达35%。而在去年出货量最大的依然是GPU,占比高达47%左右,第二名为占比34%的CPU,其次才是ASIC与FPGA,但ASIC已经隐隐有迎头赶超之势。

这里我们主要对比GPU与ASIC的差异。从特点上说,GPU更像是一大群工厂流水线上的工人,适合做大量的简单运算,很复杂的搞不了,但是简单的事情做得非常快。

与GPU不同,ASIC拥有性能高、体积小、功率低等特点,在特定领域定制后的效果远超CPU、GPU。比如,此前ASIC芯片就常被用于挖比特币。

由于ASIC芯片的设计和制造需要大量资金、较长的时间周期和工程周期,且一旦定制无法再次进行写操作,所以在模型快速迭代期,ASIC不是最优解。而随着模型迭代速度越来越慢,尤其到了应用阶段,ASIC针对特定需求开发,可根据需求对性能和功耗进行定向优化,其专用的芯片架构与高复杂度的算法相匹配,量产后在性能、功耗、成本方面均具有较大优势。

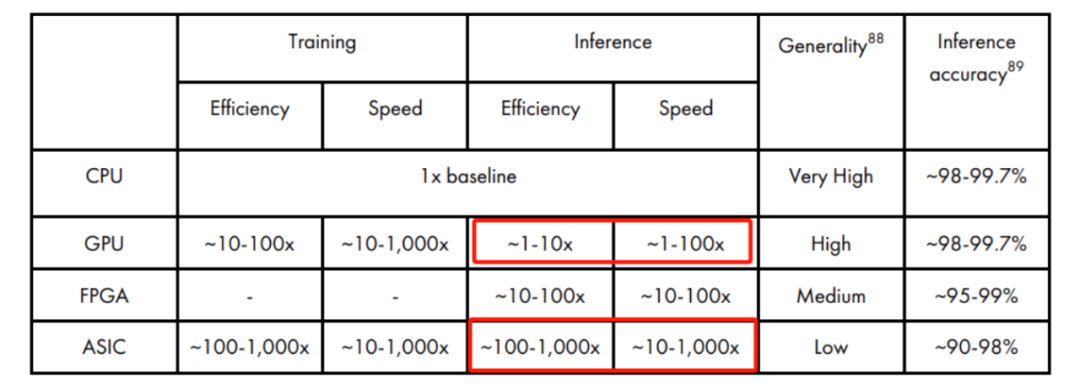

根据CSET报告《AI Chips: What They Are and Why They Matter》,相比CPU,ASIC芯片训练效率约为100-1000倍,速度约为10~1000倍。推理方面尤其好于GPU,见红框部分对比。

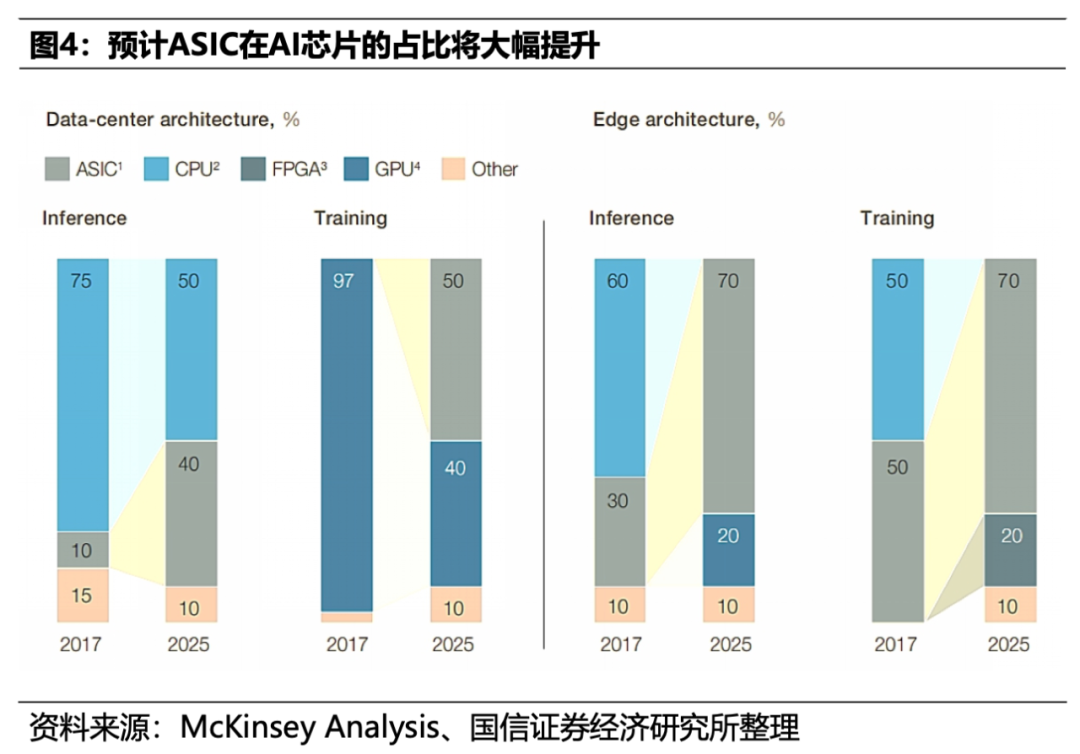

根据国海证券研报《GPT 5后NLP大模型逐步走向收敛,ASIC将大有可为》给出的数据,2025年ASIC在推理/训练应用占比分别达到40%、50%;在边缘侧,2025年ASIC在推理/训练应用占比分别达到70%、70%。

而这也解释了英伟达为什么想要布局ASIC的原因:维持自身的产业优势,不想出让这块即将到来的大蛋糕。

/ 03 / 英伟达的机会和挑战

从训练需求驱动到推理需求驱动,不仅是行业增长动力的变化,更可能是行业的一次重新洗牌。

在GPU领域,英伟达拥有绝对的统治力:根据 Liftr Insights 数据,2022 年数据中心 AI 加速市场中,英伟达份额达 82%。根据不久前的数据,2023年人工智能研究论文中使用的英伟达芯片比所有替代芯片的总和多19倍。

毫无疑问,英伟达是去年以来AI浪潮的最大赢家。2022年10月到现在,英伟达的股价从110美元左右上涨到近600美元,涨了500%。FactSet数据显示,此前20个季度,英伟达有19个季度的业绩都优于市场预期。

但ASIC的崛起,可能给英伟达带来些许变数。相比在GPU领域的一家独大,ASIC领域就显得热闹许多。

近年来,头部厂商纷纷开始切入ASIC领域,包括谷歌、英特尔、IBM在内等科技公司都有所动作。比如,2019年英特尔就收购了Habana Lab,并在2022年推出Gaudi2 ASIC芯片。

其中,谷歌在ASIC领域优势最明显。2021年推谷歌出TPU v4, 运算效能大幅提升,去年该芯片已经迭代到了v5,相比V4,训练速度和推理时间分别提高两倍和 2.5 倍。与英伟达顶级显卡A100相比,TPUv5p更是占据明显优势。根据谷歌官方数据显示,TPUv5p在训练任务上比A100快四倍以上。

尽管竞争者众,但英伟达也并非毫无优势。尤其在系统能力(软件通信算法等)上,其仍然具有明显优势。比如,目前基于自回归模型的推理是访存密集型算力,尤其是只要高并发型的应用服务,且单卡存算比例又不够的情况下,对片间互联能力的要求再次提高,NvLink的优势就再次凸显了。

据路透社同篇报道,目前英伟达已与亚马逊、Meta、微软、谷歌和OpenAI等科技巨头商讨设计ASIC芯片的合作事项,探讨创建定制芯片的机会。

尽管英伟达是否能在ASIC领域延续优势仍未可知。但有一点可以确定,随着推理需求的增加,英伟达在AI芯片领域的绝对优势将大概率被撕开一个口子,一家独家的局面将被打破。